Техническая оптимизация сайта очень важна, она может буквально разрушить все работы по внутренней оптимизации. Один единственный «/», поставленный не в том месте, и ваш сайт не увидит никто кроме вашей бабушки и кота.

robots.txt

Файл должен быть именно с таким названием и расширением»robots.txt» и расположен в корневой папке сайта.

В нем прописываются правила обхода сайта поисковыми роботами. Для всех сразу или каждой поисковой системы в отдельности: что индексировать, что не индексировать, какое зеркало будет главным, где лежит карта сайта. Это самый простой вариант конфигурации файла.

Пример:

User-agent: * Disallow: /wp-admin/ Host: http://site.ru/ Sitemap: http://site.ru/sitemap.xml

Также там можно настроить минимальный интервал между окончанием загрузки одной страницы и началом загрузки следующей во время обхода страниц.

User-agent: Yandex

Crawl-delay: 1 # задает интервал в 1 секундуВ роботсе обязательно нужно скрыть от индексации раздел админки сайта, версии для печати, страницы разных сортировок товаров и другие дубли информации.

Стоит помнить о том, часто динамические переменные создают дубли страниц, их можно, например, закрыть по шаблону:

Disallow: /*?*

или по любому другому вашему шаблону. Подробнее о разных параметрах файла robots.txt можно прочитать в справке Яндекса.

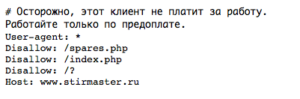

Кстати, иногда файл используется для размещения предупреждений для своих коллег:

Проверить robots.txt на ошибки можно в вебмастере Яндекса.

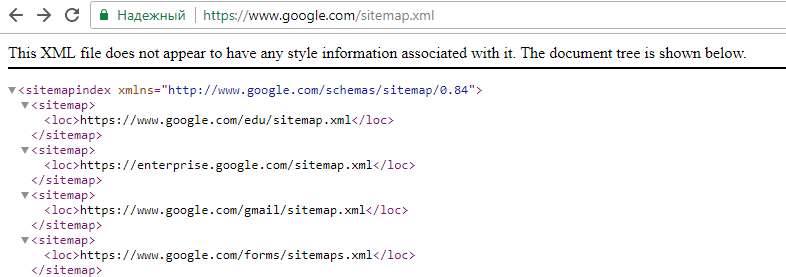

sitemap.xml

Карта сайта содержит ссылки на все страницы интернет-ресурса, время их последнего изменения и интервал обхода для робота.

Файл составлен в определенном формате xml, это карта именно для поисковых роботов, для посетителей эта карта будет непонятна.

Создается или с помощью онлайн-сервисов: тогда вы получите статичный вариант, или внутренних возможностей систем управления сайта (плагины, скрипты): тогда карта сайта будет динамической, то есть самостоятельно обновляемой.

Пример онлайн-сервиса для создания карты сайта: http://www.mysitemapgenerator.com/

Пример плагина создающего динамическую карту сайта для WP: All in One SEO Pack.

Проверить sitemap.xml на ошибки можно в вебмастере Яндекса.

Валидация

Валидация — это проверка на ошибки html-кода вашего сайта, его соответствие стандарту html5. Желательно чтобы ошибок было как можно меньше.

Для проверки используем валидатор https://validator.w3.org/ исправляем, все что можно исправить.

Редиректы

Для правильной индексации должны быть настроены редиректы с версии сайта с www на без www или наоборот ( в зависимости от главного зеркала).

Также должен быть редирект со страниц со слешем на конце на страницы без слеша.

Главная страница должна быть доступна только по одному адресу, со страниц index.php или index.html должен стоять редирект.

Проверьте что сайт не создает дублей страниц за счет добавления в адрес переменных.

Код ответа сервера

Для индексации страницы должны отдавать 200 код ответа сервера. Любой отличный код приведет к выпадению из индекса.

Код ответа сервера можно проверить в вебмастере Яндекса.

404 ошибка

Несуществующие страницы должны отдавать 404 код ответа сервера. Нужно проверять именно код ответа , а не визуальную составляющую. Зачастую бывает что 404 страница отрисована в дизайне, но отдает 200 код. Это ведет к тому, что в индексе появляется куча пустых некачественных страниц-дублей, что может понизить позиции сайта.

Отдельно отмечу , что это должна быть 404 ошибка, а не редирект на главную.

Скорость загрузки страниц

Важный параметр сайта — скорость загрузки страниц, имеет значение и для поисковиков и для пользователей. Проверить скорость загрузки страниц можно инструментом PageSpeed Insights от Google и в вебмастере Яндекса. Далее просто следуйте рекомендациям сервисов.

Чтобы сжать картинки без потери качества можно воспользоваться бесплатной программой Riot.

Mobile friendly

Еще недавно mobile friendly был не таким уж важным параметром, даже если сайт был не оптимизирован для мобильных устройств, поисковики так и продолжали выводить его на первых местах мобильной выдачи. Сейчас алгоритмы ранжирования учитывают оптимизацию сайта под мобильные устройства и в мобильной выдаче оптимизированные сайты имеют приоритет. А так как уже для многих тематик мобильный трафик составляет около 50-60 %, то игнорировать этот параметр не стоит.

Проверить оптимизацию для мобильных можно при помощи mobile friendly test google или в вебмастере Яндекса.

ЧПУ

ЧПУ расшифровывается как “человеко-понятный ULR” и предполагает, что все адреса страниц на сайте будут читаемы на латинице (транслит или перевод) и будут как заголовок Н1, отражать суть содержания страницы.

Как правило ЧПУ — это транслитерированный заголовок Н1, но если длина такого URL слишком большая, то его сокращают до разумных размеров.

https

Недавно Google заявлял что будет учитывать и повышать в выдаче сайты на https. Но на данный момент прямой зависимости для всех сайтов нет. Так как переход на https занимает некоторое время (около 1-2 месяцев), то рекомендую делать это по необходимости. Если на вашем сайте действительно обрабатываются платежи, или собирается персональная информация, то https стоит подключить. Если же ваш сайт представляет собой простой статейник, и только демонстрирует информацию, ничего не запрашивая у пользователей, можно и не переносить его на https, по крайней мере пока.

Внешние ссылки в новом окне

Если на сайте, есть ссылки на другие ресурсы, необходимо сделать так, чтобы они открывались в новой вкладке, тогда пользователь, просмотрев информацию по ссылке, может вернуться обратно на наш сайт и продолжить его изучение.

Чтобы сделать открытие ссылки в новой вкладке, в ее атрибутах нужно прописать атрибут target=»_blank» .

Проверка индексации сайта

Даже при выполнении абсолютно всех требований по технической оптимизации не ленитесь проверять индексацию сайта, с помощью запросов в Яндексе и Google:

Яндекс: url:www.site.ru/* | url:site.ru/* | url:site.ru | url:www.site.ru Google: site:site.ru

или непосредственно в вебмастере.

Бывают случаи взлома сайта и выгрузки в его каталоги огромного количества спамных страниц, заметить это можно в самом начале их индексации или уже по факту падения трафика и позиций. Иногда сами и системы управления генерируют дубликаты или некачественные полупустые страницы. Заметить все это можно только по числу роста страниц в индексе.

Индексацию отдельных важных страниц также стоит проверять. Из-за какой-нибудь глупой ошибки в robots.txt или из-за метатегов <meta name=»robots» content=»noindex, nofollow»/> они могут не индексироваться. Запросы для проверок факта индексациии страниц в выдаче:

Google: info:http://site/1.html Яндекс: url:www.site/1.html | url:site/1.html

или также можно посмотреть в вебмастере.

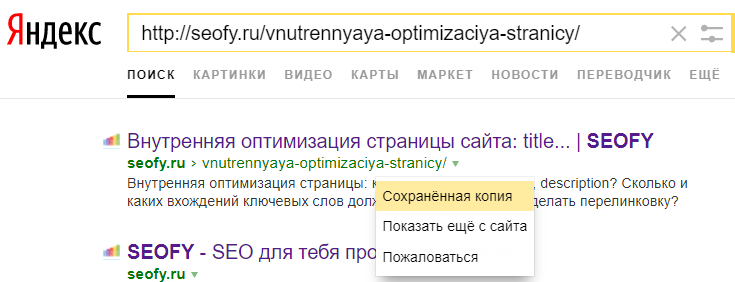

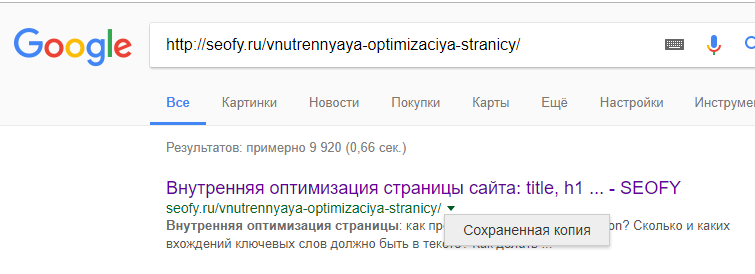

Сохраненная копия сайта

Проверить последнюю версию страниц можно в сохраненной копии сайта (стрелочка вниз рядом со ссылкой в выдаче).

Следить за индексацией страниц и другими важными параметрами удобно с помощью бесплатного плагина RDSbar.

С 2013 года работаю с поисковой оптимизацией (SEO).

C 2014 года работаю с поисковой рекламой (Яндекс.Директ/Google Ads).

С 2020 года работаю с рекламой в соц. сетях.

С 2022 года работаю с SMM.

Работала с управлением репутацией.

Мой опыт — это ваши сэкономленные деньги.

Я консультирую всех, кто обращается ко мне. Это бесплатно. Задавайте вопросы. Буду рада помочь.